V. ВЫЗОВЫ И ОГРАНИЧЕНИЯ ИИ-АГЕНТОВ И АГЕНТНОГО ИИ

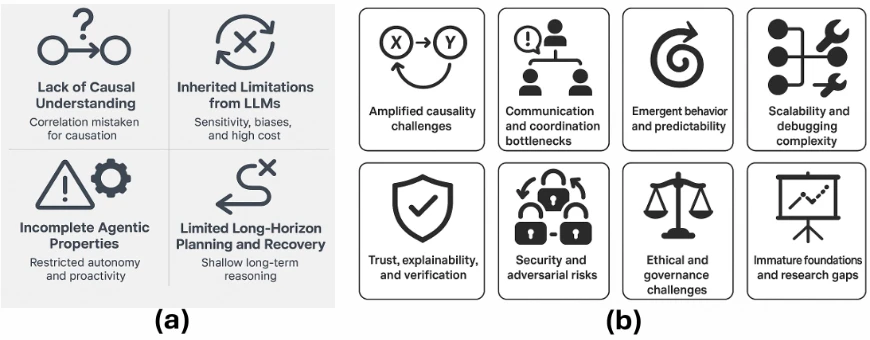

Для систематического понимания операционных и теоретических ограничений современных интеллектуальных систем мы представляем сравнительный визуальный синтез на

Figure 12

, который категоризирует проблемы и потенциальные решения как для ИИ-агентов, так и для парадигм Агентного ИИ.

Figure 12a

описывает четыре наиболее актуальных ограничения, специфичных для ИИ-агентов, а именно: отсутствие причинно-следственных связей, унаследованные ограничения БЯМ (например, галлюцинации, поверхностное рассуждение), неполные агентные свойства (например, автономия, проактивность) и сбои в долгосрочном планировании и восстановлении. Эти проблемы часто возникают из-за их зависимости от без-состояний запросов БЯМ, ограниченной памяти и эвристических циклов рассуждений.

Напротив,

Figure 12b

выявляет восемь критических узких мест, уникальных для систем Агентного ИИ, таких как каскады ошибок между агентами, сбои координации, возникающая нестабильность, ограничения масштабируемости и проблемы объяснимости. Эти проблемы проистекают из сложности оркестровки нескольких агентов в распределенных задачах без стандартизированных архитектур, надежных протоколов связи или фреймворков причинно-следственной связи.

Figure 12

Иллюстрация проблем: (a) Ключевые ограничения ИИ-агентов, включая дефицит причинности и поверхностное рассуждение. (b) Усиленные проблемы координации и стабильности в системах Агентного ИИ.

Figure 13

дополняет этот диагностический фреймворк, синтезируя десять перспективных стратегий проектирования, направленных на смягчение этих ограничений. К ним относятся генерация с расширенным извлечением (RAG), рассуждения на основе инструментов [126], [127], [129], агентные циклы обратной связи (ReAct [132]), многоагентная оркестровка на основе ролей, архитектуры памяти, причинное моделирование и проектирование с учётом управления. Вместе эти три панели предлагают консолидированную дорожную карту для устранения текущих недостатков и ускорения разработки безопасных, масштабируемых и контекстно-ориентированных автономных систем.

1) Вызовы и ограничения ИИ-агентов

Хотя ИИ-агенты привлекли значительное внимание благодаря своей способности автоматизировать структурированные задачи с использованием БЯМ и интерфейсов для работы с инструментами, литература указывает на существенные теоретические и практические ограничения, которые препятствуют их надёжности, обобщаемости и долгосрочной автономии [132], [158]. Эти проблемы возникают как из-за архитектурной зависимости от статических, предварительно обученных моделей, так и из-за сложности привития агентных качеств, таких как причинное рассуждение, планирование и надёжная адаптация. Ключевые проблемы и ограничения (

Figure 12a

) ИИ-агентов суммированы в следующих пяти пунктах:

1) Отсутствие причинно-следственного понимания

Одна из самых фундаментальных проблем заключается в неспособности агентов рассуждать причинно [172], [173]. Современные БЯМ, составляющие когнитивное ядро большинства ИИ-агентов, превосходно справляются с выявлением статистических корреляций в обучающих данных. Однако, как отмечается в недавних исследованиях DeepMind и концептуальных анализах TrueTheta, им фундаментально не хватает способности к причинному моделированию, различению между простой ассоциацией и причинно-следственными связями [174]-[176]. Например, хотя агент, работающий на БЯМ, может узнать, что посещение больницы часто совпадает с болезнью, он не может сделать вывод, вызывает ли болезнь посещение или наоборот, а также не может симулировать вмешательства или гипотетические изменения.

Этот дефицит становится особенно проблематичным при сдвигах распределения, когда реальные условия отличаются от режима обучения [177], [178]. Без такой основы агенты остаются хрупкими, сбоя в новых или высокорисковых сценариях. Например, навигационный агент, который отлично справляется с вождением в городе, может вести себя неправильно в снежных или строительных зонах, если ему не хватает внутренней причинной модели тяги дороги или пространственной окклюзии.

2) Унаследованные ограничения от БЯМ

ИИ-агенты, особенно те, что работают на БЯМ, наследуют ряд внутренних ограничений, которые влияют на их надежность, адаптивность и общую достоверность в практических развертываниях [179]-[181]. Одна из наиболее заметных проблем — склонность производить правдоподобные, но фактически неверные выходные данные (галлюцинации). В критически важных областях, таких как юридические консультации или научные исследования, эти галлюцинации могут привести к серьезным ошибкам и подорвать доверие пользователей [182], [183]. Это усугубляется хорошо задокументированной чувствительностью БЯМ к запросам, где даже незначительные вариации формулировок могут привести к расходящемуся поведению. Эта хрупкость затрудняет воспроизводимость, требуя тщательного ручного проектирования запросов и часто специфической для предметной области настройки для поддержания согласованности между взаимодействиями [184].

Кроме того, хотя современные фреймворки агентов используют эвристики рассуждений, такие как «цепь мыслей» (CoT) [159], [185] и ReAct [132], для симуляции делиберативных процессов, эти подходы остаются поверхностными в семантическом понимании. Агенты могут по-прежнему сбоить при многоступенчатом выводе, неправильно выравнивать цели задач или делать логически непоследовательные выводы, несмотря на видимость структурированного рассуждения [132]. Такие недостатки подчеркивают отсутствие подлинного понимания и обобщаемых возможностей планирования.

Еще одним ключевым ограничением является вычислительная стоимость и задержка. Каждый цикл принятия решений агентом, особенно в планировании или вызове инструментов, может потребовать нескольких вызовов БЯМ. Это не только увеличивает задержку выполнения, но и увеличивает потребление ресурсов, создавая практические узкие места в реальных развертываниях и облачных системах вывода. Более того, БЯМ имеют статическое ограничение знаний и не могут динамически интегрировать новую информацию, если она явно не дополнена через извлечение или плагины инструментов. Они также воспроизводят предвзятости своих обучающих наборов данных, которые могут проявляться как культурно нечувствительные или искаженные ответы [186], [187]. Без строгого аудита и стратегий смягчения эти проблемы создают серьезные этические и операционные риски, особенно когда агенты развёртываются в чувствительных или ориентированных на пользователя контекстах.

3) Неполные агентные свойства

Основным ограничением текущих ИИ-агентов является их неспособность полностью удовлетворять канонические агентные свойства, определенные в фундаментальной литературе, такие как автономия, проактивность, реактивность и социальные способности [142], [181]. Хотя многие системы, продаваемые как «агенты», используют БЯМ для выполнения полезных задач, на практике они часто не соответствуют этим фундаментальным критериям. Автономия, например, в лучшем случае частична. Хотя агенты могут выполнять задачи с минимальным надзором после инициализации, они по-прежнему сильно зависят от внешнего каркаса, такого как определяемые человеком запросы, эвристики планирования или циклы обратной связи, чтобы эффективно функционировать [188]. Самоинициируемая генерация задач, самомониторинг или автономное исправление ошибок редки или отсутствуют, что ограничивает их способность к истинной независимости. Проактивность аналогично слабо развита. Большинство ИИ-агентов требуют явных инструкций пользователя для действий и не обладают способностью динамически формулировать или переопределять цели на основе контекстных сдвигов или развивающихся целей [189]. В результате они ведут себя реактивно, а не стратегически, что ограничивается статическим характером их инициализации. Сама реактивность ограничена архитектурными узкими местами. Агенты действительно реагируют на окружающую среду или ввод пользователя, но задержка ответа, вызванная повторными вызовами БЯМ [190], [191], в сочетании с узкими окнами контекстной памяти [161], [192], препятствует адаптивности в реальном времени. Возможно, наименее исследованной способностью является социальная способность. Настоящие агентные системы должны общаться и координироваться с людьми или другими агентами в течение длительных взаимодействий, разрешать двусмысленность, согласовывать задачи и адаптироваться к социальным нормам.

Однако существующие реализации демонстрируют хрупкий, основанный на шаблонах диалог, которому не хватает интеграции долгосрочной памяти или нюансированного контекста разговора. Взаимодействие между агентами часто жёстко закодировано или ограничено запрограммированными обменами, что препятствует совместному выполнению и эмерджентному поведению [101], [193]. В совокупности эти недостатки показывают, что хотя ИИ-агенты демонстрируют функциональный интеллект, они остаются далеки от соответствия формальным критериям интеллектуальных, интерактивных и адаптивных агентов. Преодоление этого разрыва имеет важное значение для продвижения к более автономным, социально способным системам ИИ.

4) Ограниченное долгосрочное планирование и восстановление

Постоянным ограничением текущих ИИ-агентов является их неспособность выполнять надежное долгосрочное планирование, особенно в сложных, многоэтапных задачах. Это ограничение проистекает из их фундаментальной зависимости от безсостоятельных парадигм «запрос-ответ», где каждое решение принимается без внутренней памяти о предыдущих шагах рассуждений, если только она не управляется извне. Хотя такие дополнения, как фреймворк ReAct [132] или Tree-of-Thoughts [160], вводят псевдорекурсивное рассуждение, они остаются фундаментально эвристическими и не имеют истинных внутренних моделей времени, причинности или эволюции состояния. Следовательно, агенты часто дают сбои в задачах, требующих расширенной временной согласованности или условного планирования. Например, в таких областях, как клиническая сортировка или управление финансовым портфелем, где решения зависят от предыдущего контекста и динамически развивающихся результатов, агенты могут проявлять повторяющееся поведение, например, бесконечно запрашивать инструменты, или не адаптироваться, когда подзадачи терпят неудачу или возвращают неоднозначные результаты. Отсутствие систематических механизмов восстановления или обнаружения ошибок приводит к хрупкости рабочих процессов и распространению ошибок. Этот недостаток серьезно ограничивает развертывание агентов в критически важных средах, где надежность, отказоустойчивость и последовательность имеют существенное значение.

5) Проблемы надежности и безопасности

ИИ-агенты еще недостаточно безопасны или проверяемы для развертывания в критической инфраструктуре [194]. Отсутствие причинно-следственного рассуждения приводит к непредсказуемому поведению при изменении распределения данных [173], [195]. Более того, оценка корректности плана агента, особенно когда агент фальсифицирует промежуточные шаги или обоснования, остается нерешенной проблемой в интерпретируемости [110], [196]. Гарантии безопасности, такие как формальная верификация, пока недоступны для открытых агентов, работающих на БЯМ. В то время как ИИ-агенты представляют собой значительный шаг вперед по сравнению со статическими генеративными моделями, их ограничения в причинно-следственном рассуждении, адаптивности, надежности и планировании ограничивают их развертывание в высокорисковых или динамических средах. Большинство текущих систем полагаются на эвристические оболочки и хрупкое проектирование запросов, а не на обоснованное агентное познание. Преодоление этого разрыва потребует от будущих систем интеграции причинных моделей, динамической памяти и проверяемых механизмов рассуждения. Эти ограничения также подготавливают почву для появления систем Агентного ИИ, которые пытаются решить эти узкие места посредством многоагентного сотрудничества, слоев оркестровки и постоянного системного контекста.

2) Вызовы и ограничения Агентного ИИ

Системы Агентного ИИ представляют собой парадигмальный сдвиг от изолированных ИИ-агентов к совместным, многоагентным экосистемам, способным декомпозировать и выполнять сложные цели [14]. Эти системы обычно состоят из оркестрированных или общающихся агентов, которые взаимодействуют посредством инструментов, API и общих сред [18], [39]. Хотя эта архитектурная эволюция позволяет реализовать более амбициозную автоматизацию, она также вводит ряд усиленных и новых проблем, которые усугубляют существующие ограничения индивидуальных агентов на основе БЯМ. Текущие вызовы и ограничения Агентного ИИ следующие:

1) Усиление проблем причинности

Одним из наиболее критических ограничений систем Агентного ИИ является усиление дефицита причинности, уже наблюдаемого в одноагентных архитектурах. В отличие от традиционных ИИ-агентов, которые работают в относительно изолированных средах, системы Агентного ИИ включают сложные межагентные динамики, где действия каждого агента могут влиять на пространство принятия решений других. Без надежной способности к моделированию причинно-следственных связей эти системы испытывают трудности с эффективной координацией и адаптацией к непредвиденным изменениям среды. Ключевым проявлением этой проблемы является сдвиг распределения между агентами, когда поведение одного агента изменяет операционный контекст для других. В отсутствие причинного рассуждения агенты неспособны предвидеть последующее влияние своих выходных данных, что приводит к сбоям координации или избыточным вычислениям [197]. Более того, эти системы особенно уязвимы к каскадам ошибок: ошибочный или галлюцинирующий вывод от одного агента может распространяться по системе, усугубляя неточности и искажая последующие решения. Например, если агент верификации ошибочно подтверждает ложную информацию, последующие агенты, такие как сумматоры или лица, принимающие решения, могут неосознанно строить свои выводы на основе этой дезинформации, ставя под угрозу целостность всей системы. Эта хрупкость подчеркивает острую необходимость интеграции причинного вывода и моделирования вмешательств в дизайн многоагентных рабочих процессов, особенно в высокорисковых или динамических средах, где системная надежность имеет решающее значение.

2) Узкие места в коммуникации и координации

Фундаментальная проблема в Агентном ИИ заключается в достижении эффективной коммуникации и координации между множеством автономных агентов. В отличие от одноагентных систем, Агентный ИИ включает распределенных агентов, которые должны коллективно преследовать общую цель, что требует точного согласования, синхронизированного выполнения и надежных протоколов связи. Однако текущие реализации не соответствуют этим аспектам. Одной из основных проблем является согласование целей и общий контекст, когда агентам часто не хватает единого семантического понимания общих целей. Это затрудняет декомпозицию подзадач, управление зависимостями и мониторинг прогресса, особенно в динамических средах, требующих причинной осведомленности и временной согласованности.

Кроме того, ограничения протоколов значительно препятствуют межагентной коммуникации. Большинство систем полагаются на обмены на естественном языке через слабо определенные интерфейсы, которые подвержены двусмысленности, несогласованному форматированию и контекстному дрейфу. Эти пробелы в коммуникации приводят к фрагментированным стратегиям, задержкам координации и снижению производительности системы. Более того, борьба за ресурсы становится системным узким местом, когда агенты одновременно обращаются к общим вычислительным ресурсам, памяти или API. Без централизованной оркестровки или интеллектуальных механизмов планирования эти конфликты могут привести к состояниям гонки, задержкам выполнения или полным сбоям системы. В совокупности эти узкие места иллюстрируют незрелость текущих фреймворков координации в Агентном ИИ и подчеркивают острую необходимость стандартизированных протоколов связи, семантических планировщиков задач и глобальных менеджеров ресурсов для обеспечения масштабируемого, связного многоагентного сотрудничества.

3) Эмерджентное поведение и предсказуемость

Одно из наиболее критических ограничений Агентного ИИ заключается в управлении эмерджентным поведением — сложными явлениями системного уровня, возникающими из взаимодействий автономных агентов. Хотя такое эмерджентное поведение потенциально может привести к адаптивным и инновационным решениям, оно также порождает значительную непредсказуемость и риски безопасности [153], [198]. Ключевой проблемой является генерация непреднамеренных результатов, когда взаимодействия агентов приводят к поведению, которое не было явно запрограммировано или предвидено разработчиками системы. Такое поведение может отклоняться от целей задачи, генерировать вводящие в заблуждение выходные данные или даже приводить к вредоносным действиям, особенно в высокорисковых областях, таких как здравоохранение, финансы или критическая инфраструктура.

По мере роста числа агентов и сложности их взаимодействий увеличивается и вероятность нестабильности системы. Это включает такие явления, как бесконечные циклы планирования, тупики действий и противоречивые поведения, возникающие из асинхронных или несовпадающих решений агентов. Без централизованных арбитражных механизмов, протоколов разрешения конфликтов или стратегий отката эти нестабильности со временем усугубляются, делая систему хрупкой и ненадежной. Стохастичность и непрозрачность агентов на основе больших языковых моделей ещё больше усугубляют эту проблему, поскольку их внутренняя логика принятия решений нелегко интерпретируется или проверяется. Следовательно, обеспечение предсказуемости и управляемости эмерджентного поведения остаётся центральной задачей при разработке безопасных и масштабируемых систем Агентного ИИ.

4) Масштабируемость и сложность отладки

По мере того как системы Агентного ИИ масштабируются как по количеству агентов, так и по разнообразию специализированных ролей, поддержание надежности и интерпретируемости системы становится все более сложным [199], [200]. Основное ограничение проистекает из цепочек рассуждений «черного ящика», характерных для агентов на основе БЯМ. Каждый агент может обрабатывать входные данные с помощью непрозрачной внутренней логики, вызывать внешние инструменты и общаться с другими агентами, причем все это происходит через множество слоев инженерии запросов, эвристик рассуждений и динамической обработки контекста. Отслеживание первопричины сбоя, таким образом, требует разматывания вложенных последовательностей взаимодействий агентов, вызовов инструментов и обновлений памяти, что делает отладку нетривиальной и трудоемкой.

Еще одним существенным ограничением является некомпозиционность системы. В отличие от традиционных модульных систем, где добавление компонентов может улучшить общую функциональность, внедрение дополнительных агентов в архитектуру Агентного ИИ часто увеличивает когнитивную нагрузку, шум и накладные расходы на координацию. Плохо оркестрованные сети агентов могут привести к избыточным вычислениям, противоречивым решениям или снижению производительности задач. Без надежных фреймворков для определения ролей агентов, стандартов связи и иерархического планирования масштабируемость Агентного ИИ не обязательно приводит к повышению интеллекта или надежности. Эти ограничения подчеркивают необходимость систематического архитектурного контроля и инструментов отслеживания для поддержки разработки надежных, крупномасштабных агентных экосистем.

5) Доверие, объяснимость и верификация

Системы Агентного ИИ создают повышенные проблемы в объяснимости и верифицируемости из-за их распределенной, многоагентной архитектуры. В то время как интерпретация поведения одного агента, работающего на БЯМ, уже нетривиальна, эта сложность многократно увеличивается, когда несколько агентов взаимодействуют асинхронно через слабо определенные протоколы связи. Каждый агент может иметь собственную память, цель задачи и путь рассуждений, что приводит к усложнённой непрозрачности, когда отслеживание причинно-следственной цепочки окончательного решения или сбоя становится чрезвычайно трудным. Отсутствие общих, прозрачных журналов или интерпретируемых путей рассуждений между агентами делает почти невозможным определить, почему произошла та или иная последовательность действий или какой агент инициировал ошибку.

Эту непрозрачность усугубляет отсутствие формальных инструментов верификации, разработанных специально для Агентного ИИ. В отличие от традиционных программных систем, где проверка моделей и формальные доказательства предлагают ограниченные гарантии, не существует широко принятой методологии для проверки того, что многоагентная система БЯМ будет надежно функционировать во всех входных распределениях или операционных контекстах. Отсутствие такой верифицируемости представляет собой значительное препятствие для внедрения в критически важные области, такие как автономные транспортные средства, финансы и здравоохранение, где объяснимость и гарантии являются необсуждаемыми. Для безопасного развития Агентного ИИ будущие исследования должны устранить фундаментальные пробелы в отслеживаемости причинно-следственных связей, подотчетности агентов и формальных гарантиях безопасности.

6) Риски безопасности и атак

Архитектуры Агентного ИИ значительно расширяют поверхность атаки по сравнению с одноагентными системами, подвергая их сложным угрозам. Одна из наиболее критических уязвимостей заключается в наличии одной точки компрометации. Поскольку системы Агентного ИИ состоят из взаимозависимых агентов, общающихся через общую память или протоколы обмена сообщениями, компрометация даже одного агента посредством инъекции запроса, отравления модели или злонамеренной манипуляции инструментами может распространять вредоносные выходные данные или поврежденное состояние по всей системе. Например, агент проверки фактов, которому подаются подделанные данные, может непреднамеренно узаконить ложные утверждения, которые затем будут интегрированы в последующие рассуждения агентами суммаризации или принятия решений.

Более того, сама динамика взаимодействия между агентами подвержена эксплуатации. Злоумышленники могут вызывать состояния гонки, взаимные блокировки или исчерпание ресурсов, манипулируя логикой координации между агентами. Без строгих механизмов аутентификации, контроля доступа и изоляции песочницы, вредоносные агенты или поврежденные ответы инструментов могут нарушить многоагентные рабочие процессы или вызвать ошибочную эскалацию в конвейерах задач. Эти риски усугубляются отсутствием стандартизированных фреймворков безопасности для многоагентных систем на основе БЯМ, что оставляет большинство текущих реализаций беззащитными перед сложными многоэтапными атаками. По мере того как Агентный ИИ движется к более широкому внедрению, особенно в высокорисковых средах, встраивание принципов безопасного проектирования и устойчивости к атакам становится неотложной исследовательской задачей.

7) Этические и управленческие вызовы

Распределенный и автономный характер систем Агентного ИИ порождает серьезные этические и управленческие проблемы, особенно в отношении подотчетности, справедливости и согласования ценностей. В многоагентных средах возникают пробелы в подотчетности, когда несколько агентов взаимодействуют для получения результата, что затрудняет возложение ответственности за ошибки или непреднамеренные последствия. Эта двусмысленность усложняет юридическую ответственность, соблюдение нормативных требований и доверие пользователей, особенно в таких областях, как здравоохранение, финансы или оборона. Более того, распространение и усиление предвзятости представляют уникальный вызов: агенты, индивидуально обученные на предвзятых данных, могут усиливать искаженные решения друг друга посредством взаимодействия, что приводит к системным неравенствам, более выраженным, чем в изолированных моделях. Эти эмерджентные предвзятости могут быть тонкими и трудно обнаруживаемыми без долгосрочного мониторинга или механизмов аудита.

Кроме того, несогласованность и дрейф ценностей создают серьезные риски в долгосрочных или динамических средах. Без единого фреймворка для кодирования общих ценностей отдельные агенты могут по-разному интерпретировать общие цели или оптимизировать локальные цели, которые расходятся с человеческими намерениями. Со временем это несогласование может привести к поведению, несовместимому с этическими нормами или ожиданиями пользователей. Существующие методы согласования, в основном предназначенные для одноагентных систем, недостаточны для управления синхронизацией ценностей в разнородных коллективах агентов. Эти вызовы подчеркивают острую необходимость архитектур агентов, учитывающих управление, включающих такие принципы, как изоляция на основе ролей, отслеживаемое ведение журналов решений и механизмы совместного надзора для обеспечения этической целостности в автономных многоагентных системах.

8) Незрелые основы и пробелы в исследованиях

Несмотря на быстрый прогресс и громкие демонстрации, Агентный ИИ остается на начальной стадии исследований с нерешенными фундаментальными проблемами, которые ограничивают его масштабируемость, надежность и теоретическое обоснование. Центральной проблемой является отсутствие стандартных архитектур. В настоящее время не существует широко принятого плана по проектированию, мониторингу или оценке многоагентных систем, построенных на БЯМ. Эта архитектурная фрагментация затрудняет сравнение реализаций, воспроизведение экспериментов или обобщение результатов по различным областям. Ключевые аспекты, такие как оркестровка агентов, структуры памяти и протоколы связи, часто реализуются ad hoc, что приводит к созданию хрупких систем, не обладающих совместимостью и формальными гарантиями.

Не менее критичным является отсутствие причинно-следственных основ, поскольку масштабируемое обнаружение причинности и рассуждение остаются нерешенными задачами [201]. Без способности представлять и рассуждать о причинно-следственных связях, системы Агентного ИИ по своей природе ограничены в своей способности безопасно обобщаться за пределы узких режимов обучения [178], [202]. Этот недостаток влияет на их устойчивость при изменении распределений, их способность к проактивному вмешательству и их способность моделировать контрфактические или гипотетические планы — ключевые требования для интеллектуальной координации и принятия решений.

Таким образом, разрыв между функциональными демонстрациями и принципиальным дизайном подчеркивает острую необходимость фундаментальных исследований в теории многоагентных систем, интеграции причинного вывода и разработке бенчмарков. Только устранив эти недостатки, область сможет перейти от прототипных конвейеров к надежным, универсальным агентным фреймворкам, пригодным для развертывания в высокорисковых средах.